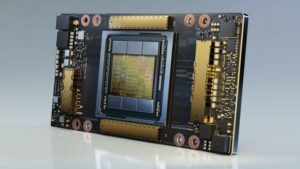

NVIDIA A100 SXM4版 発表 新世代AmpereアークテクチャGPU

2020.05.19

AI/Deep Learningにも、HPCにも対応した新世代のGPGPUの登場です。

これまでのNVIDIA V100と比較して、AI推論でピーク時20倍のスループットを達成しますが、AIのみならずデータ分析、科学技術計算、エンコードなどのグラフィックス用途においても卓越したコンピューティング性能を発揮します。

まずインターコネクトがNVLink3.0対応(SXM4)製品よりリリースが開始されます。PCIeカード製品はPCIe Gen4対応で、その後にリリースされる予定です。

VTはこれらの製品を一刻も早くご提供し、研究開発にご活用いただけるよう準備を進めております。

お気軽にお問い合わせください。

【NVIDIA A100 SXM4 のポイント】

- 全般的な基本性能の底上げ

- データ型の拡張と疎行列(Sparse matrix)に最適化された第3世代 Tensorコア

AI/機械学習を中心とするBF16、TF32、Int8、Int4に加え、HPC分野を想定したFP64(倍精度浮動小数点数)もサポート - 第3世代 NVLink 及びPCIe Gen4対応

- 1つのGPUを最大7分割して使用可能

- 帯域1.5TB/s な HBM2 40GB メモリ

- TSMCの7nmプロセスで製造

- A100に対応する CUDA11 toolkit

【性能】

FP32(単精度浮動小数点数) 312TFLOPS (TF32使用時。V100の20倍)

FP64(倍精度浮動小数点数) 19.5TFLOPS(TensorコアがFP64サポート。同2.5倍)

INT8(8bit整数演算) 1,248TOPS(ディープラーニング推論処理用。同20倍)

詳細はスペック比較表 参照

【特徴】

◎第3世代 TensorコアとFP32演算性能

浮動小数点の仮数部を10Bitとした(通常のFP32は23Bit)「Tensor Float (TF32) 」精度でのFP32性能は、312TFLOPSに及びます(Tensorコアを使わない場合のFP32性能は 19.5TFLOPS)。

また密行列(Dense Matrix)を疎行列(Sparse matrix)に置き換える演算方式(「Structural sparsity」ハードウェアプルーニングによるスパース化)を有効にすることで、2倍程度の性能を発揮します。

◎Multi-instance GPU(MIG)

1GPUを最大7個のGPUに分割可能

◎メモリ帯域 1.5TB/s の HBM2メモリを40GB搭載

◎第3世代 NVLink

最大 12 本の第 3 世代 NVLink 接続をサポート

帯域幅の合計 600 GB/s(V100の第2世代NVLinkの2倍、PCIe Gen4の約10倍)

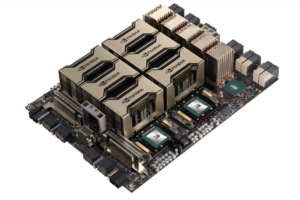

NVIDIA HGX A100:NVIDIA A100 8基をNVSwitchで接続したリファレンスOEM基盤例

【リンク】

NVIDIA A100 TENSOR コア GPU

NVIDIA HGX A100 NVLink

CUDA11 Features Revealed