[RAG(検索拡張生成)] 簡単にLLMの精度向上! オンプレに構築、ご相談ください

2024.06.20

RAGを使って手軽にLLMの精度UP!

RAGとは

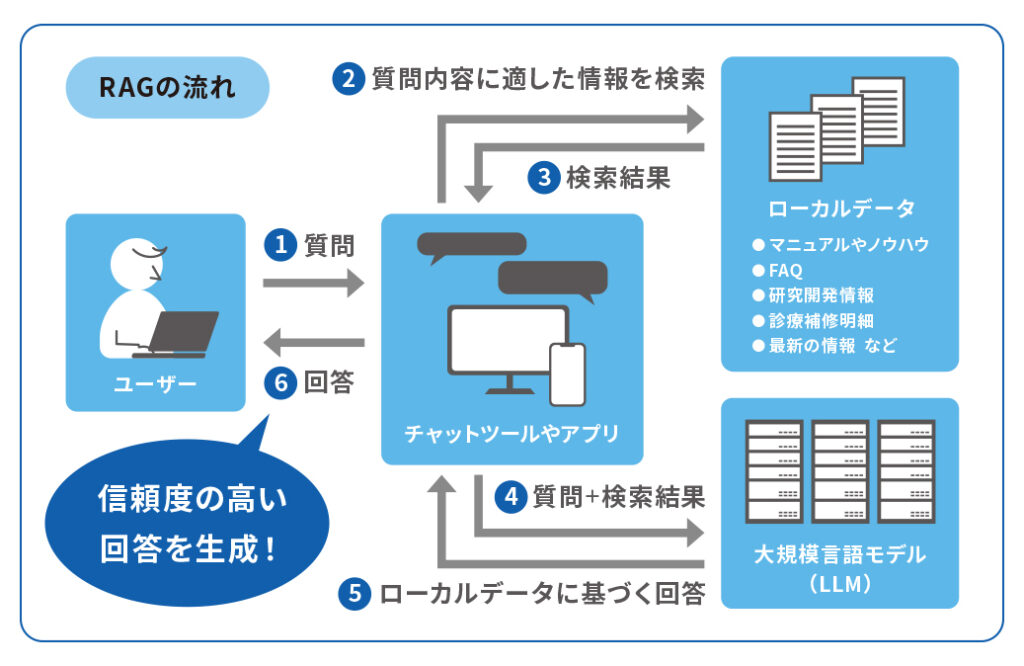

大規模言語モデル(LLM)に、ローカルデータへの検索を組み合わせることで、

正確な情報に基づいた回答を生成させる技術です。

※もちろんPhi-3などのSLMでの活用も!

RAGのメリット

1) LLMが出力する結果を、手軽に最新情報に更新することができる

2) 信頼度の高いデータから情報を得るため、AIが学習データと相容れない誤情報を生成する

“ハルシネーション(幻覚)”の抑制につながる

→ LLMの回答精度を向上させます!

ファインチューニングがありますが・・・

・ ローカルデータによる追加学習(再学習):Deep Learningで行われるようなファインチューニングでは、回答にローカルデータが確実に選択される保証がない!

・ 大規模モデルでは処理に多大なリソースが必要。故に、気軽に再学習できないので学習データは古くなりがち。

最先端のRAGをオンプレミスで!

あなたのデータを最大限に活用

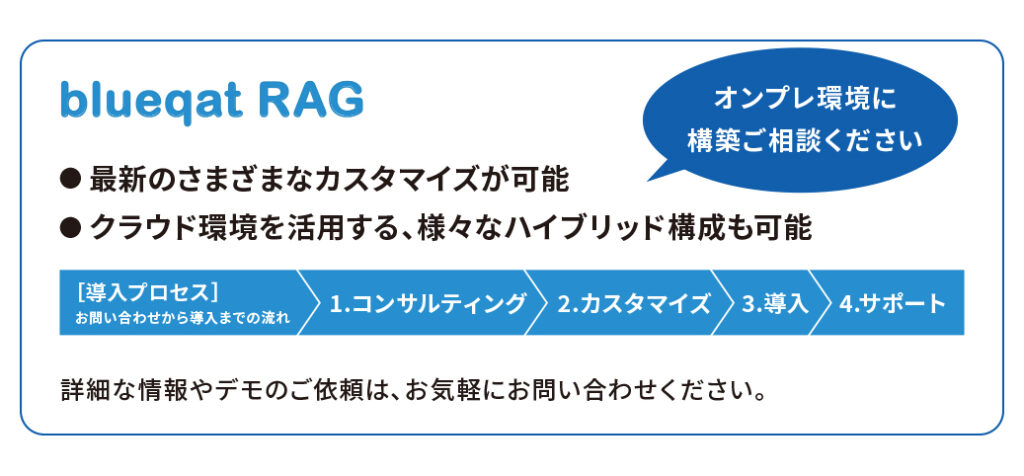

最新AI技術のRAGをオンプレミス環境で導入し、セキュリティとパフォーマンスを両立

RAG×オンプレ 主なメリット

セキュリティ :クエリとデータが社内に留まるため、最高レベルのセキュリティを実現

パフォーマンス :オンプレミス環境での高いパフォーマンス

カスタマイズ :企業のニーズに合わせた柔軟なカスタマイズが可能

コスト :クラウドサービス費用の削減

RAG×オンプレ 技術的な特徴

RAG :高精度な情報検索と生成機能を統合し、より正確で有用な情報提供を実現

オンプレミス :自社のインフラを活用し、安定した運用と高速なアクセスを提供

:ローカルデータの任意のタイミングでの更新に対応

▼ チラシはこちらからご覧いただけます

★ ご質問・ご相談、どんなことでもお気軽にお問い合わせください。

詳細なご説明を含めオンラインでのヒアリング・お打ち合わせから承ります。